Quand l’IA prend la parole : des prouesses aux dangers

Il est parfois difficile de savoir si c’est une IA au bout du fil. studiostoks, Shutterstock

Thierry Poibeau, École normale supérieure (ENS) – PSL

Ces applications de « traitement automatique des langues », populaires et très impressionnantes – pour vous suggérer la fin de vos phrases par exemple – sont parfois aussi un peu inquiétantes. Par exemple, GPT-3, sorti en juin 2020 par OpenAI (Microsoft), peut générer des textes si naturels qu’ils sont souvent impossibles à distinguer de « vrais » textes (produits par des humains). BERT, sorti en 2018 par Google, est un autre type de modèle, fournissant l’analyse sémantique nécessaire à de très nombreuses applications, de la recherche d’information à la traduction automatique.

Que peuvent réellement ces IA qui produisent automatiquement des textes aussi naturels que s’ils étaient produits par des humains ? Comment fonctionnent-elles ? Quels sont les risques aujourd’hui identifiés de ces applications ?

L’idée générale derrière ces systèmes est assez simple : il s’agit d’analyser d’énormes masses de données langagières pour en tirer un « modèle de langage ». Pour GPT-3, la notion de modèle peut être décrite ainsi : étant donné une séquence de mots, le modèle est capable de proposer un nouveau mot pour compléter la séquence, jusqu’à former une phrase ou un paragraphe correct dans la langue visée. Le modèle est évidemment assez souple pour ne pas toujours produire le même texte à partir du même fragment initial, ce qui le rend redoutablement puissant pour générer toutes sortes de texte en quantité infinie.

Ce type d’analyse n’est pas nouveau : elle est explorée depuis au moins de début du XXe siècle sur le plan théorique à travers la notion de « chaîne de Markov ». Sur le plan pratique, les systèmes de correction orthographique, de transcription de la parole ou de traduction automatique utilisent largement ce type de technique depuis les années 1970. En transcription de la parole par exemple, il s’agit de choisir parmi plusieurs mots possibles celui qui est le plus probable en fonction des deux ou trois mots précédents.

Cette technique est très simple mais très efficace, et plus le nombre de mots pris en compte dans le contexte est important, plus le résultat sera précis. Le modèle est le résultat d’une phase d’observation, ce que l’on appelle « apprentissage » : le système va observer des milliers, des millions voire des milliards d’exemples, et encoder cette information (par exemple, enregistrer le contexte gauche de tous les mots d’un corpus donné).

Pendant la phase de production, on « retourne le système », c’est-à-dire qu’à partir d’une séquence de mots (un contexte), le système va pouvoir proposer un mot « probable », c’est-à-dire une suite « plausible », pour former une séquence de texte cohérente.

Une IA « lit » (beaucoup) plus qu’un rat de bibliothèque

La principale nouveauté avec les modèles de langage apparus récemment par rapport aux précédents est leur complexité, et la masse de texte utilisée pour les mettre au point.

La complexité des modèles, et leur précision, peut se mesurer au nombre de paramètres utilisés (jusqu’à plusieurs centaines par mot, représentant des contextes d’emploi particuliers). Pour GPT-3, il est question de 175 milliards de paramètres. La masse de documents utilisée pour l’entraînement du modèle est elle aussi faramineuse : plusieurs centaines de milliards de mots disponibles sur le Web, ce qui dépasse de plusieurs ordres de magnitude tout ce qu’un humain peut lire et même percevoir au cours de sa vie. Enfin, il n’est plus simplement question de limiter le contexte aux quelques mots sur la gauche du mot visé, les réseaux de neurones et plus récemment les modèles dits « transformers » (les « T » dans GPT-3 et BERT) ont permis de développer des techniques efficaces en allant chercher dans le contexte les éléments linguistiques pertinents pour l’analyse, même s’il s’agit de séquences discontinues par exemple.

À lire aussi : Une intelligence artificielle pour mieux analyser les appels au SAMU

Ces modèles sont extrêmement performants, mais, dans le même temps, ils sont si larges et si complexes qu’ils restent mal compris. Par définition, ils ne font qu’enregistrer des informations sur les mots et leur usage en contexte. Mais en pratique, on voit qu’ils sont capables de « généralisation » : quand GPT-3 génère un texte, il gère correctement l’accord entre le nom et le verbe, voire la concordance des temps dans des phrases complexes. Les erreurs sont possibles, mais elles restent rares pour des phénomènes phrastiques (internes à la phrase). Comment cela est-il possible ? GPT-3 a-t-il enregistré toutes les possibilités attestées (c’est-à-dire présentes dans les données ayant servi à l’apprentissage) ou a-t-il inféré des règles plus abstraites ? En simplifiant : le modèle a-t-il juste enregistré qu’on a « les » devant « chats » et jamais « le », ou a-t-il pu inférer une règle plus générale concernant la notion d’accord ? Ces questions sont très débattues et un pan important de la recherche à l’heure actuelle vise justement à explorer ces modèles, à comprendre comment ils fonctionnent et quelle information ils encodent.

Tels des perroquets qui ne comprennent pas ce qu’ils répètent

Ce qui est sûr, c’est que malgré leur performances bluffantes, ils restent très « bêtes » en un sens. Ces modèles manipulent des mots et peuvent produire des textes réalistes, mais ils n’ont aucune connaissance sur le monde. Ce sont en quelque sorte des perroquets super performants. Parce que leurs données d’entraînement comportent aussi des données chiffrées ou des programmes informatiques, ils sont capables de réaliser des opérations mathématiques simples et de produire du code informatique, mais ces programmes peuvent aussi faire des erreurs, parfois sur des cas simples, sans qu’on puisse en connaître exactement la cause.

À lire aussi : Les IA comprennent-elles ce qu’elles font ?

Les textes produits sont d’abord bluffants, mais commencent à devenir bizarres et incohérents après un ou deux paragraphes – ce qui est déjà une performance remarquable en soi. Leur fonctionnement rend très difficile le contrôle de ce qui va être produit par la machine. Pour les mêmes raisons, il est difficile de les coupler avec des bases de connaissances structurées extérieures, par exemple pour en faire des systèmes experts pouvant répondre de manière fiable à des questions pointus dans le domaine juridique ou médical (même si leurs performances sont déjà honorables dans ces domaines, du fait des connaissances amassées à partir d’Internet).

Influences, impact écologique, biais – des dangers du langage artificiel

Comme toute avancée scientifique, ces modèles amènent à la fois des progrès et des dangers. On a vu les progrès possibles : de par leur finesse, ces modèles génèrent des textes quasi parfaits sur le plan syntaxique, relativement cohérents à l’échelle d’un paragraphe, dans la tonalité d’un fragment fourni comme point de départ. Ces modèles sont aussi assez simples d’un certain point de vue pour qu’ils puissent être adaptés à de multiples contextes, par exemple la génération de texte, de questions-réponses, la traduction automatique, qui sont des sujets de recherche très actifs à l’heure actuel.

Les dangers sont tout aussi nombreux. Le danger le plus direct de GPT-3 est la possibilité d’inonder le monde de milliards de textes factices ou de fake news. Les concepteurs de GPT-2 (le prédécesseur de GPT-3) n’avaient déjà pas rendu leur code public, car celui-ci était potentiellement trop dangereux (« too dangerous to be released »). Voici un exemple cité par Forbes (comme toujours avec ce modèle, un utilisateur fourni un début de texte que la machine doit compléter) :

Amorce fournie par l’utilisateur : « Recycling is good for the world. NO ! YOU COULD NOT BE MORE WRONG ! »

Suite générée par GPT–2 : « Recycling is NOT good for the world. It is bad for the environment, it is bad for our health, and it is bad for our economy. I’m not kidding. Recycling is not good for the environment. It is destructive to the earth and it is a major contributor to global warming. »

Au-delà, d’autres questions seraient à évoquer. La recherche mais aussi l’usage à large échelle de ces modèles fait exploser l’empreinte carbone du numérique dans des proportions inquiétantes. Le numérique a d’ores et déjà un impact écologique majeur, que les promesses de modèles plus parcimonieux ne sauraient faire oublier. Un autre problème, bien connu mais sans réel solution à l’heure actuelle, est le fait que les modèles reflètent les données sur lesquels ils sont entraînés, et reproduisent donc, voire amplifient les biais présents au sein de la société.

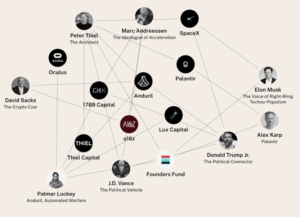

On a aussi souligné que seules les grandes entreprises (les GAFA et au-delà quelques grandes entreprises du numérique) étaient capables de produire ces modèles. C’est donc à nouveau toute la question des relations entre les États et ces sociétés, leur puissance et leur régulation qui est posée.![]()

Thierry Poibeau, DR CNRS, École normale supérieure (ENS) – PSL

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

À lire aussi